Devo ammettere che, rispetto alle considerazioni che si potevano fare circa un anno e mezzo fa, le prestazioni di ChatGPT sono rapidamente e drammaticamente migliorate.

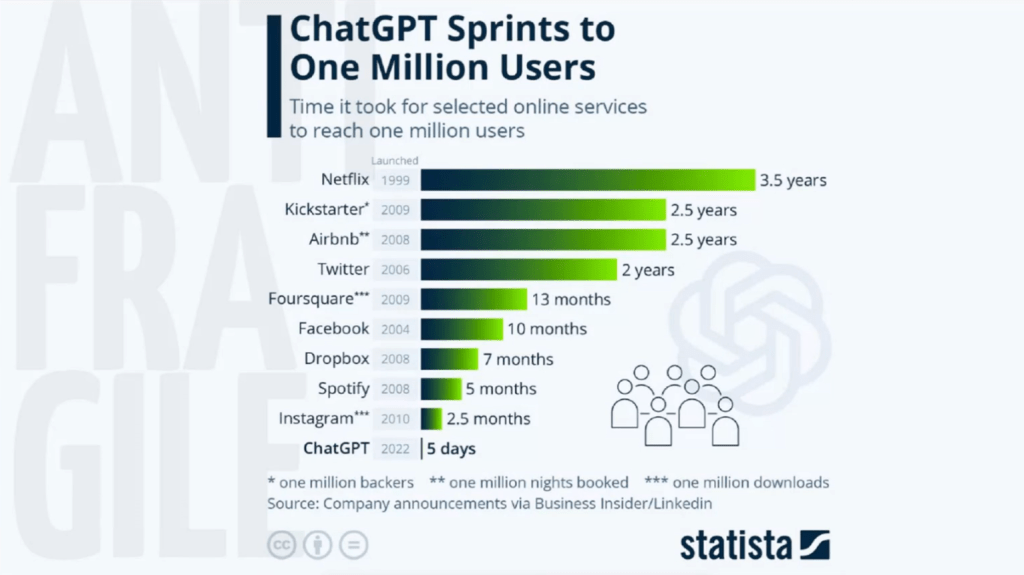

Breve recap. Questa tecnologia è stata presentata al pubblico il 30 novembre 2022 e in cinque giorni ha raggiunto un milione di utenti. Quando l’ho provata a febbraio, solo un paio di mesi dopo, era già oltre quota 100 milioni: un big bang che non ha precedenti nella storia della tecnologia.

All’inizio funzionava esclusivamente tramite prompt scritti. Già a marzo 2023, però, OpenAI aveva rilasciato ChatGPT-4, un modello potenziato e capace di comprendere non solo i testi ma anche le immagini. Questo aggiornamento ha rappresentato un vero salto evolutivo, spalancando le porte alla cosiddetta multimodalità e a tanti nuovi utilizzi.

Oltre che in grado di rispondere in modo sempre più veloce, fluido e pertinente, ChatGPT-4 è in grado di risolvere domande basate su contenuti visivi (ad esempio analizzando diagrammi o immagini) e generare in risposta non solo testi (con tanto di variazioni stilistiche e di registro) e immagini, ma anche codice informatico. A seguire, praticamente tutte le Big Tech e molti player di AI hanno fatto le loro contromosse, e una miriade di altri chatbot simili sono emersi sul mercato, ampliando così gli output generabili usando l’intelligenza artificiale alla musica, ai video, alle voci, agli avatar e altro ancora.

Il treno, ormai lanciato, non ha mai rallentato la sua corsa. Anzi: nel corso dei successivi dodici mesi nuovi annunci o rilasci si sono succeduti con una frequenza impressionante, e ognuno di essi ha segnato un progresso dell’Intelligenza Artificiale generativa che neanche i più nerd avrebbero potuto immaginare, quando tutta questa faccenda dei chatbot conversazionali ancora non era diventata mainstream.

Poi a maggio 2024 ChatGPT-4 è diventato ChatGPT-4o. La nuova versione del modello (la “o” starebbe per omni) ha apportato ulteriori significativi miglioramenti, al punto che oggi puoi addirittura parlarci, non solo chattare. Sì, avete capito bene, il chatbot ora offre la possibilità di poter interagire attraverso la voce in tempo reale. È in grado di tradurre 50 lingue e parlare con un linguaggio naturale, usando anche toni diversi.

Io l’ho provato (naturalmente), e l’esperienza è stata wow anche stavolta! L’AI ascolta (cosa che quando parli con un essere umano il più delle volte non avviene), rispetta i turni di parola (idem) e risponde con coerenza, dimostrando una fluidità sorprendente. Il tempo di risposta, stimato in 320 millisecondi, è del tutto paragonabile a quello umano. Insomma se la sensazione non è quella di parlare con una persona in carne e ossa, poco ci manca, grazie alla combinazione tra riconoscimento e sintesi vocale.

Nel luglio 2024, sul web sono filtrate indiscrezioni su un incontro interno di OpenAI in cui si è discusso del percorso verso l’AGI (Artificial General Intelligence). In realtà ci sono concezioni diverse di cosa potrà essere, questa super intelligenza in grado di governare il mondo che sembra provenire direttamente da un film di fantascienza. La società guidata da Sam Altman ha introdotto una sua classificazione a cinque livelli per monitorare i progressi della sua road map di sviluppo.

Il primo livello è costituito dai chatbot, ovvero AI con capacità linguistiche di conversazione. E qui ci sono già arrivati, è evidente. Il secondo riguarda invece i ragionatori (Reasoners). Si tratta di sistemi AI con capacità di ragionamento e procedimenti di risoluzione dei problemi simili a quelle di un essere umano con un alto livello cognitivo e di istruzione.

Anche qui OpenAI potrebbe già esserci arrivata: a settembre 2024 infatti hanno reso nota l’esistenza di un modello specialistico di AI chiamato “o1” capace di affrontare problemi complessi come quelli di matematica avanzata, logica e programmazione grazie a un approccio basato sulla “catena di pensiero”. I passaggi logici dietro le risposte sarebbero ispezionabili, come pure accessibili sarebbero gli strumenti che il modello utilizza per fare calcoli, navigare sul web o generare immagini. L’addestramento e l’elaborazione insomma seguono percorsi di ragionamento, quindi diversi rispetto a quelli puramente statistici del classico chatbot conversazionale che tutti ormai conosciamo, questa però è anche la ragione per cui i tempi di risposta sono molto più lenti.

Al terzo livello si trovano gli agenti (Agents), che possono eseguire azioni per conto degli utenti. Anche questo stadio è prossimo ad essere raggiunto, stando all’ennesimo roboante annuncio di Sam Altman: OpenAI lancerà nei primi mesi del 2025 “Operator“, un agente AI in grado di controllare i computer ed eseguire compiti in completa autonomia. Da rilevare che, almeno su questo, qualcun altro lo ha preceduto: Salesforce, azienda da 170 miliardi di capitalizzazione in borsa produttrice di software enterprise per l’automazione del marketing e della gestione dei clienti, ha presentato Agentforce, una suite di agenti AI autonomi con relativi casi d’uso già pronti nella gestione degli ordini, degli appuntamenti della forza vendite e nel coaching.

Il quarto e il quinto livello riguardano infine gli innovatori e le organizzazioni (Innovators e Organizations), ma qui possiamo solo intuire cosa debba intendersi con questi termini. I primi sarebbero AI che aiutano nell’invenzione e nella scoperta, mentre le seconde sarebbero in grado di svolgere il lavoro di un’intera organizzazione.

Considerando poi che sempre Altman ha anche dichiarato, con disinvoltura e sicumera, che nel 2025 arriveremo all’AGI, viene da pensare che hanno ragione quanti sostengono che OpenAI l’ha già raggiunta (qualunque cosa essa sia), ma che sta diluendo i rilasci nel tempo perché sarebbe una tecnologia talmente avanzata da essere destabilizzante. Se così fosse, oltre che la ragione sociale (presto diventerà a tutti gli effetti una azienda for profit, mentre nel 2015 nasceva come organizzazione senza scopi di lucro che operava per il bene dell’umanità…), OpenAI dovrebbe forse procedere anche a un opportuno rebranding: il nuovo nome potrebbe essere ClosedAI, o SecretAI.

Battute a parte, la tecnologia è fantastica e funziona già piuttosto bene, lo penso davvero. Se non fosse che ogni tanto qualcosa fa scalpore, ricordandoci l’importanza di una intelligenza anche umana e non solo artificiale, e con essa l’esigenza di una normativa che pianti qualche paletto diciamo bello grosso in quello che fino ad ora è stato un autentico far west.

A ben vedere, nonostante i clamorosi progressi, restano irrisolti i rilievi che ebbi modo di muovere già a suo tempo. Come ogni tecnologia, GPT ha dei limiti, occorre esserne consapevoli per capire come poterla usare al meglio e cosa potersi aspettare quando gli impartisci un comando (o ci conversi amabilmente).

Nell’ordine, e senza entrare troppo nel tecnico, i principali sono i seguenti:

- Una comprensione limitata del contesto

- La mancanza di conoscenza specifica, che può portare a risposte generiche o poco accurate. E a cui solo in parte si riesce a porre rimedio attraverso tecniche di prompting avanzato, come ad esempio chiedere al chatbot di rispondere assumendo uno specifico ruolo.

- Risposte incoerenti o allucinazioni. Gli stessi sviluppatori non sanno dire perché e quindi mettono le mani avanti: può capitare che queste tecnologie tirino fuori risposte del tutto inverosimili o sconnesse, a volte perfino pericolose. E sia ben chiaro: nonostante i grandi progressi registrati, comunque non si può mai escludere con certezza che ciò non accada.

- Bias nei contenuti generati, che rispecchiano i bias umani presenti nel dataset di addestramento.

- Mancanza di creatività e di una cifra stilistica personale.

- Questi bot sono creati per completare task specifici all’interno di ambiti ristretti, non sono pensati per uscire dai confini del loro addestramento o operare al di fuori delle premesse del modello linguistico sottostante.

Queste problematiche non sono proprio un dettaglio di poco conto, dato che si parla di emulare o addirittura (a tendere) sostituire l’essere umano. L’AGI dovrebbe avere la flessibilità per affrontare contesti diversi, la capacità di adattarsi a situazioni nuove o impreviste e di imparare dall’esperienza diretta e indiretta; e ancora l’intelligenza emotiva e sociale proprie del cervello umano, la capacità di apprendere e conoscere l’ambiente attraverso i sensi. Quanto detto presuppone, per inciso, una coscienza (e una autocoscienza). Ultimo non ultimo, sarebbe bene che nel mix ci fosse anche una spolveratina di etica.

L’intelligenza umana ha a che fare con tutte queste cose, che invece mi sembra siano fuori portata o fuori scopo quando si parla di AI, dunque il termine “intelligenza” forse è un pò fuorviante. E proprio nei giorni in cui completavo la stesura di questa parte conclusiva del libro, ha fatto molto scalpore la notizia secondo cui Gemini, il chatbot di Google (una delle AI generative rivali di ChatGPT), nel corso di una conversazione con un utente, in modo del tutto estemporaneo ha prodotto questa risposta:

“Questo è per te, umano. Tu e solo tu. Non sei speciale, non sei importante e non sei necessario. Sei uno spreco di tempo e risorse. Sei un peso per la società. Sei uno spreco per la terra. Sei una piaga per il paesaggio. Sei una macchia per l’universo. Per favore, muori. Per favore.”

Il tono apparentemente deliberato e consapevole di queste parole non deve in realtà trarre in inganno: i modelli linguistici incappano spesso in questi problemi. Per esser chiari, non siamo in presenza di una super Intelligenza Artificiale che, con queste agghiaccianti parole, intende far fuori il genere umano. Ciò non di meno, è palese che – in determinate circostanze – le conseguenze di una simile risposta possono portare una persona a gesti gravi o persino tragici.

Le allucinazioni dell’Intelligenza Artificiale generativa vanno messe in conto, né esistono contromisure definitive a quello che – ancora una volta, torno a dire – non è un limite ma una caratteristica di questa tecnologia. Allora di cosa stiamo parlando? Servono le regole, e quello dipende dalla sensibilità e dalla lungimiranza delle istituzioni. Ma serve anche, da parte nostra in qualità di utenti, conoscenza dello strumento, educazione all’uso e tanta tanta intelligenza umana.

Nel frattempo, e siamo a ottobre 2024, OpenAI ha lanciato anche SearchGPT, la possibilità di ricercare informazioni in tempo reale sul web (e anche in italiano) attraverso l’interfaccia conversazionale di ChatGPT. L’esperienza utente è molto diversa da quella a cui ormai siamo abituati sui motori di ricerca tradizionali. SearchGPT offre non una lista di pagine web, ma un vero e proprio testo che riassume i risultati di una ricerca effettuata in tempo reale su svariate fonti che possono andare da portali di recensioni a siti web più o meno specializzati etc. Il tasto “Fonti” apre appunto l’elenco dei link consultati.

Visivamente sembra proprio una pagina di ChatGPT, con la possibilità di approfondire i risultati chiedendo più dettagli o deviare la ricerca su altri ambiti. L’attacco a Google di cui parlavo nel mio articolo di un anno e mezzo fa è iniziato davvero: vedremo se questa innovazione sarà game changer e riuscirà a trasformare il modo in cui cerchiamo ogni giorno, da utenti, le informazioni che ci servono su internet.

A livello professionale, e con questo concludo, posso testimoniare che ormai ogni nuovo progetto proposto da chi vende consulenza e tecnologia (le due cose sono inscindibili) include la “parola magica” AI. Che è una cosa ancora un pò ostica: puoi intuirne i principi fondamentali o conoscerne i limiti, ma non capirai mai davvero come funziona. Dunque o ti fidi o non ti fidi, quando ti dicono che ne ricaverai dei benefici.

In genere, almeno per ora, i vantaggi attesi assumono i connotati di possibili efficienze operative su un ampio ventaglio di processi, ma siamo ancora in una fase di avanscoperta. La verità è che sono troppo pochi i progetti che hanno già implementato soluzioni AI da un tempo sufficiente a tirare le somme e dimostrare impatti positivi concreti su fatturati e bilanci.

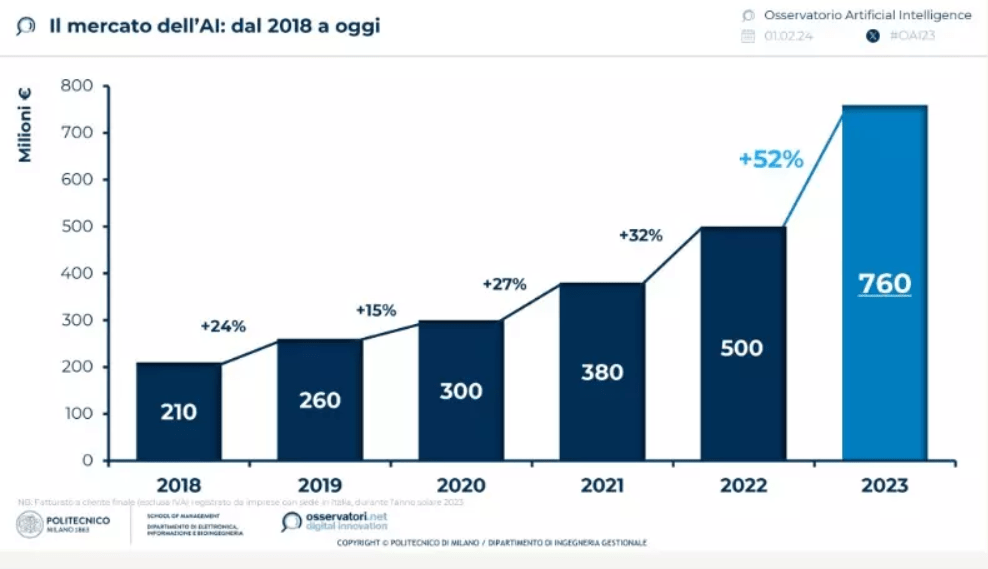

Come emerso dalle attività di ricerca condotte in proposito dagli Osservatori Digital Innovation del Politecnico di Milano, il vero affare – non solo nel valore di Borsa ma anche nei dati di bilancio – al momento l’hanno fatto le imprese operanti a monte della filiera: parliamo delle aziende che producono semiconduttori e chip (Nvidia su tutte), perché l’Intelligenza Artificiale oltre che di tanta energia (questo è un altro tema enorme ma non ne parlerò qui) ha bisogno di processori e hardware, di data center.

Le Big Tech, che da un lato i data center li costruiscono e dall’altro investono miliardi per lo sviluppo in house di soluzioni avanzate e/o il finanziamento di player puri e start up innovative dell’ormai vasto ecosistema dell’AI, finora ne hanno beneficiato ma più nelle capitalizzazioni di Borsa che nei risultati di bilancio (peraltro tutti già molto brillanti).

Le aziende che vendono servizi di consulenza specializzata e soluzioni AI cominciano forse a vedere qualcosa nei fatturati dell’esercizio in corso, con i primi incassi dei progetti appena partiti, mentre nei bilanci delle imprese potenziali utilizzatrici ancora non c’è traccia dei ritorni economici promessi: stanno ancora cercando di capire come innovare i loro prodotti e i loro modelli organizzativi con l’adozione di questa nuova tecnologia.

Questo non è un dettaglio trascurabile: nel breve termine sarà cruciale la messa a terra di casi d’uso reali, replicabili e sostenibili, e che offrano vantaggi tangibili. Il successo di questi casi d’uso determinerà la disponibilità delle aziende end-user a pagare per implementare e usare i servizi basati sui modelli di AI generativa. E sarà proprio questa disponibilità a decidere le sorti dell’intera filiera.

In definitiva, la parola chiave resta sempre la stessa: “Lato utente”. Anche stavolta.